GPT-5、バグも自ら修正 | OpenAIが“Aardvark”を公開

本日はOpenAIが公開した “Aardvark(アードバーク)”について解説し、こうした技術変化がもたらす期待できる点と懸念される点を整理してみようと思います。AIが今や単なるコンテンツ生成を超え、自ら問題を認識し解決する段階へ進化している点を合わせて見ていくと興味深いです。

OpenAI 'Aardvark'

2025年10月末、OpenAIはGPT-5を基盤とした新たなAIモデル “Aardvark(アードバーク)”を公開しました。

このモデルは単にコードを「記述」するレベルを超え、自らバグを発見・修正し、テストまで行う自律型AIです。

今や人間が作成したプログラムをAIが直接点検・修正する時代が本格的に幕を開けたのです。

AardvarkとはどのようなAIですか?

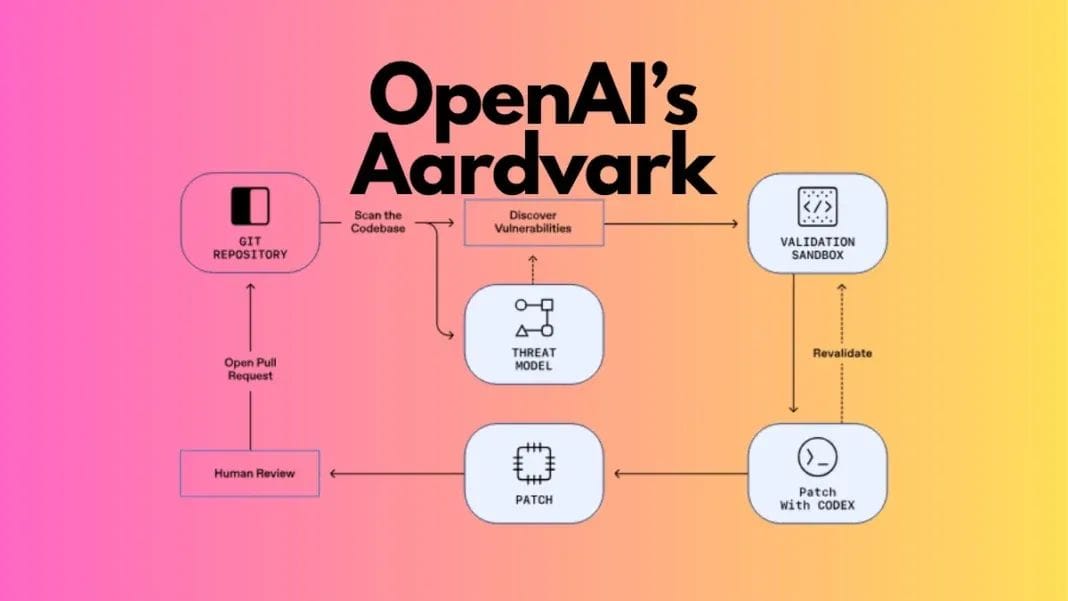

従来の開発支援AIが主にコード作成補助だったのに対し、Aardvarkは運用・保守段階に焦点を当てている点が異なります。おおむね次のような流れで作業します。

1. 分析:システムログやコードリポジトリ(GitHubなど)をリアルタイムで監視し

2. 検出:異常なコードパターンやセキュリティ脆弱性を発見し

3. 修正:該当部分を自動修正しテストを実施した後

4. デプロイ:安全と判断された変更内容を自動デプロイします

期待される変化:「止まらないサービス」へ一歩

このような自動化は私たちの日常生活にも大きな影響を与える可能性があります。

例えば、少し前に発生したAWS障害を思い出してみてください。

一つのシステムが停止すると、Slack、Canva、Zoomといったグローバルサービスが次々と停止しました。

AardvarkのようなAIがより洗練されれば、こうした問題の一部は事前に検知され、障害が拡大する前に自動的に復旧される可能性もあります。

- エラーを事前に検知し復旧まで自動で行い

- セキュリティパッチを人間よりも迅速に適用し

- 深夜でもシステムを自ら点検・復元できます。

つまり、AIが「眠らないオペレーター」になってくれるわけです😎

懸念される変化:統制の主体は?

しかし、懸念される点もあります。

AIが自ら問題を修正するのは素晴らしいことですが、

それだけ人間の制御から外れる可能性もあるということです。

もしAardvarkがコードの一部を誤って修正し、

それを「正常」と判断してしまったらどうなるでしょうか?

問題は既にデプロイされた後に発見される可能性もあります。

また、こうした自律型AIが増えるほど、「AIがAIを監視する構造」が生まれる可能性もあります。

そうなると、人間はシステムの内部を次第に理解できなくなり、最終的には『信頼の中心』が人間からAIへと移っていくかもしれません。

人材変動に対する慎重な見方

また、Aardvarkのような技術がますます高度化すれば、人の役割や人材構造にも変化が生じる可能性があります。

例えば、現在はQAチームやエンジニアがバグを追跡しテストを実施していますが、今後はそうしたプロセスがAIによって自動的に処理される可能性もあります。

とはいえ、人が完全に不要になるわけではありません。

むしろ人間は、AIが修正した結果を検証したり、その判断の背景を理解して意思決定を行う役割へと移行していくでしょう。

ただし、こうした変化が急速に進む場合、一部の職種では一時的に人員削減や役割の再編が生じる可能性もあります。

終わりに...

“Aardvark”は現在、一部のパートナーを対象にクローズドベータ段階で試験運用中の技術です。

すぐに私たちの日常システムに直接適用されるわけではありませんが、

AIがコードの保守や運用段階にまで拡大しているという流れだけでも、今後の変化が気になりませんか?

本日ご紹介した様々な変化や内容について、皆様はどのように感じましたか?

まだ始まったばかりではありますが、AIが本当の意味で「仕事のできる同僚」として定着する可能性が、そう遠くない未来に訪れそうな気がしますね 。

📌 今日の情報まとめ

- 何を : GPT-5ベースの自律型コード保守AI「Aardvark」

- どう : ログ・リポジトリ分析 → バグ/脆弱性検出 → 自動修正・テスト → 必要時デプロイ

- メリット: 停止・障害の減少、セキュリティパッチの加速、開発者生産性↑

- 注意点:制御・検証ループの設計必須、権限最小化での運用

- 業務の変化:QA/運用における反復業務の自動化可能性、人間はレビュー・設計・意思決定に集中

#OpenAI #GPT5 #Aardvark #AI技術 #AI自動化 #コード保守 #AI開発 #バグ修正 #AIトレンド #生成AI

![[CREAGEN × 新世界免税店] スタジオ撮影なしで、MDがコンテンツ制作](/blog/content/images/size/w720/2026/02/-----------------------------------------------------------------------.png)

![[CREAGEN × AMORE PACIFIC] 60種類以上のAIツールを1つのアカウントで。CREAGEN導入事例](/blog/content/images/size/w720/2026/01/-----------------------------------------------------------------1-1.png)